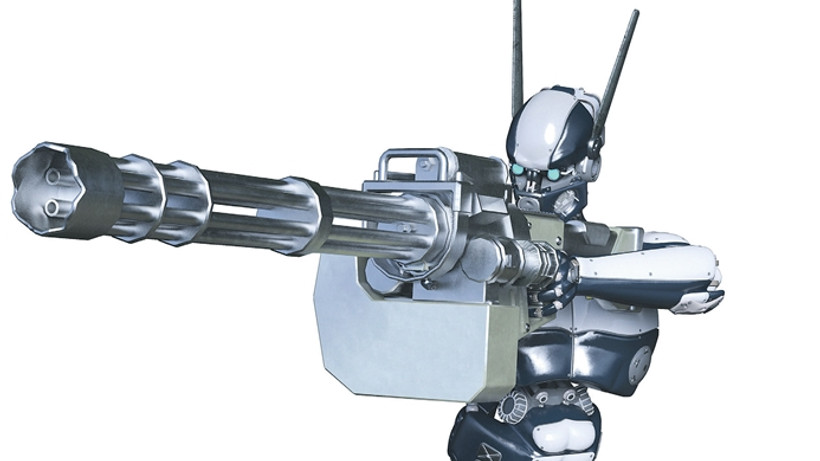

Savaşan yapay zeka

Donanım ve yazılım konusunda o kadar hızlı bir gelişme kaydediyoruz ki, daha sonra kontrol edemeyeceğimiz bir teknoloji üretip kendi kendimizin felaketi olabiliriz. Peki bu durumdan kaçınmak için gerçekten bir şeyler yapılıyor mu?

Yapay zeka ve robotik gibi birçok işi insan iradesinin dışında yönetebilmemizi sağlayan teknolojilerin geleceğine ilişkin karamsar görüşler sır değil. Elon Musk, Steve Wozniak ya da yakın zamanda aramızdan ayrılan Stephen Hawking gibi yüksek profilli ve gündem belirleyici kişiler, özelde hükümetlerin ve genelde ise Birleşmiş Milletler gibi uluslarüstü kuruluşların yapay zeka sistemleri ile çalışan silahların geliştirilmesine ve kullanılmasına kısıtlamalar koyulması çağrısında bulunuyorlar. Nedeni ise çok basit. Füze, roket ya da herhangi ölçekte bombaların insan kontrolünün dışında otonom olarak faaliyet gösterdiği bir aşamaya ulaşmamız halinde, sonuçların korkunç olabileceğini düşünüyorlar. PEKİ HAKSIZLAR MI?

Evet haksızlar, hiç korkmaya lüzum yok demek isterdik. Fakat durum pek öyle kolay değil. Çok basit bir örnek üzerinden otonom karar veren teknolojilerin karıştığı bir olayı hatırlamakta fayda var. Geçtiğimiz ay ABD'nin Arizona eyaletinde gerçekleşen sürücüsüz aracın karıştığı bir kaza, darbe alan yayanın ölümü ile sonuçlandı. Kazada yayanın ya da aracın suçlu olup olmamasına bakmaksızın, bu kaza olmayabilir miydi diye düşünmek gerekiyor. Kaza üzerine araştırmalar sürse de, gündeme gelen bir bilgi aracı yöneten otonom sürücü yazılımının hassasiyeti ile ilgiliydi. Aktarılan bilgiye göre kaza sırasında yazılım, aracın sürekli dur-kalk yapmasının engellenmesi adına hareketli cisimlere hassasiyeti azaltılmış bir şekilde test ediliyormuş. Elbette aracı kaza sırasında yazılım kontrol ediyor olsa da, direksiyon başında gerçek bir sürücü de testi kontrol etmek ve acil müdahale için bekliyordu. Buna rağmen kaza gerçekleşti. Ancak bu örnekten çıkarılabilecek şöyle bir sonuç var ve önemli olan da bu; günün birinde tamamen yapay zeka tarafından yönetilen bir araç yaya hassasiyeti, araç içindekilerin yaşamsal durumu, olası kaza halinde neyi feda edeceği konusunda nasıl kararlar verecek. Bunları bilmiyoruz ve savaşan makinelere oranla oldukça barışçıl bir konu olan otonom araçlarda dahi böyle sorunlar gündeme gelebiliyor.

General yapay zeka

Geçtiğimiz haftalarda yapay zeka alanında faaliyet gösteren 50'den fazla bilim insanı, otonom silahlar geliştirmek için savunma sanayisi firmalarıyla ortak proje geliştiren Kore İleri Bilim ve Teknoloji Enstitüsü (KAIST) ile akademik iş birliği yapmama kararı almıştı. KAIST, dünyanın önde gelen robot ve bilim laboratuvarlarından biri. KAIST araştırmacıları, sıvı pillerden hastalık sensörlerine kadar birçok teknoloji geliştiriyorlar. Çok geçmeden tepkilere yanıt veren KAIST Rektörü Sung-Chul Shin, bildiriye imza atan bilim insanlarını sakinleştirmeyi başarmıştı.Rektör de savunmayı bu noktadan başlatıyor, teknoloji geliştirmek üzere hareket ettiklerini ama insan iradesini dışlayan bir çalışma sürdürmeyeceklerini açıklıyordu. Pek tatmin edici bir argüman olmasa da, tepkinin ciddiye alındığını gösterdi.

Bu konu daha çok su kaldırır ve herkes bunun farkında. Birleşmiş Milletler otonom savaş teknolojilerinin kısıtlanmasına ilişkin geniş kapsamlı bir organizasyon gerçekleştirmek üzere kolları sıvadı. Bu yıl sonuna doğru yapılacak bu etkinlikten neler çıkacak, göreceğiz.